-

[Mac] Open Webui + LM Studio 설정하기HomeLAB/Mac(OSX, macOS) 2025. 2. 1. 22:15

맥북에서 LLM을 구동시키기 위한 여러 가지 프로그램이 있지만 모델 다운로드부터 멀티 모달 모델까지 한 번에 올인원으로 사용 가능한 부분이 마음에 들어 Ollama를 사용했습니다. Open Webui 같은 API를 사용 가능한 프로그램이 거진 필수인 것까지는 괜찮은데 제대로 사용하려면 터미널에서 사용해야 하고 로그를 확인하는 것이 불편했으며 LLM 모델 관리가 잘 안 돼서 요즘은 LM Studio를 주로 사용하고 있습니다.

LM Studio 자체로도 훌륭한 프로그램이지만, 좀 더 많은 활용을 위하여 Open Webui를 사용해 볼 겁니다.

https://lmstudio.ai/docs/api/endpoints/openai

위 링크를 확인해 보면 LM Studio API는 OpenAI API와 호환되게끔 만들어져 있어서 Open Webui에서도 OpenAI API의 URL만 로컬로 수정해 놓으면 사용할 수 있습니다.

기본적인 구성은 맥북의 호스트에서 LM Studio를 실행시키고 Docker로 Open Webui를 실행시켜서 API 주소를 변경하는 방법을 사용합니다.

0. 시스템 사양

Apple MacBook Pro 16

CPU: M3 MAX

RAM: 64GB

OS: macOS Sequoia 15.2

LM Studio 버전: 0.3.8

1. LM Studio(Host) 세팅

먼저 LM Studio의 세팅을 진행합니다. 먼저 왼쪽 아래에 있는 유저 타입을 변경합니다. 기본 설정이 Power User로 되어있어서 그대로 해도 되지만, 저는 Developer로 변경해 줄 겁니다. 변경하지 않아도 딱히 크게 문제는 없습니다. 다만, User로 설정만 안 해놓으면 됩니다.

세팅을 해야 하는 기본 화면입니다. 왼쪽의 탭에서 터미널 모양의 두 번째 탭을 클릭하면 서버를 설정할 수 있는 창이 나옵니다. 여기에서 설정을 진행하면 됩니다.

저는 앱 언어를 한국어(Beta)로 변경했는데 영어이신 분들은 위치 확인해 보고 설정하시면 됩니다.

Settings에서 Server Port가 1234로 기본 설정 되어있습니다. 저는 기본 포트를 사용하는걸 별로 안 좋아해서 서버 포트를 변경해 줬습니다.

맥북을 서버로 사용하고 싶다면 '로컬 네트워크에서 제공' 설정을 켜면 됩니다. 요즘 M4 맥미니가 가성비로 나와서 그런지 서버로 사용하시려는 분들이 많더라고요. 그런 경우에는 이 옵션을 켜야 다른 컴퓨터에서 API를 사용할 수 있습니다.

그 외에는 적당히 기본 설정으로 하거나 저랑 동일하게 맞춰주시면 됩니다.

그리고 Status 부분의 스위치를 누르면 서버가 시작됩니다. 이러면 LM Studio의 설정이 끝납니다.

2. Open Webui(Docker) 세팅

docker compose로 서비스를 실행할 겁니다.

아래는 docker-compose.yaml 구성입니다.

더보기# 참고: https://docs.openwebui.com/getting-started/quick-start/ services: openwebui: image: ghcr.io/open-webui/open-webui:main container_name: open-webui restart: unless-stopped ports: - 3000:8080 volumes: - ./open-webui-data:/app/backend/data extra_hosts: - "host.docker.internal:host-gateway"extra_hosts 가 중요한데 이 부분이 있어야 호스트 서버에 접속할 수 있습니다.

docker compose up -d이후 서비스를 실행합니다.

Open Webui를 실행하고 나면 오른쪽 위에 아이콘이 있는데 누르면 관리자 패널이 있습니다. 관리자 패널로 들어가면 각종 여러 가지 설정이 가능합니다.

설정 - 연결로 들어가 보면 OpenAI API 설정이 있습니다. 여기에서 OpenAI API 연결 관리의 오른쪽에서 + 버튼을 누릅니다.

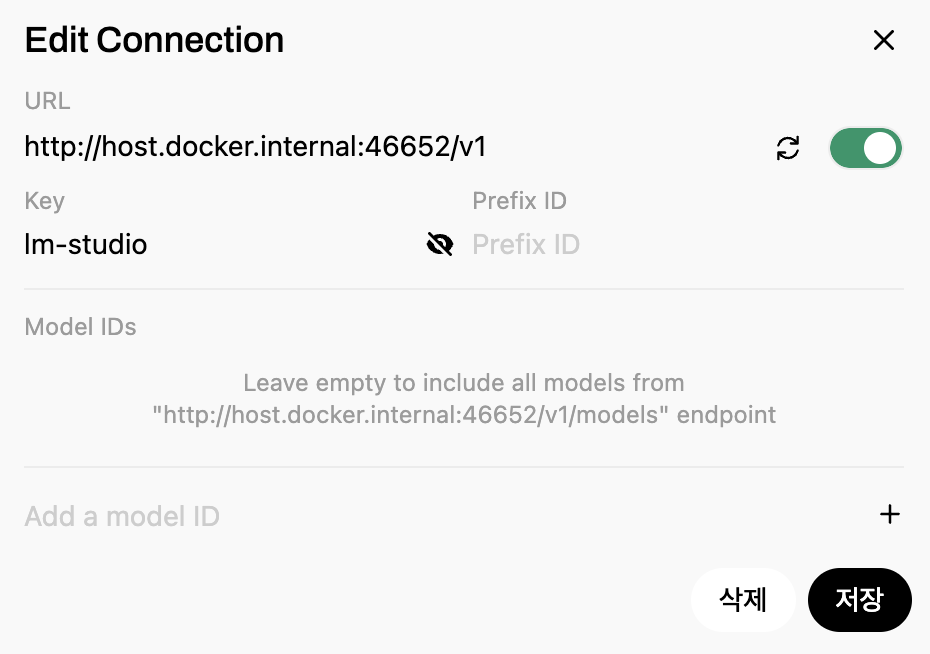

이미지처럼 세팅하면 됩니다. 아래에서 복사 붙여 넣기 하면 됩니다.

URL: http://host.docker.internal:46652/v1

# Key는 아무렇게나 적어도 상관없는 것 같습니다.

Key: lm-studio확인해 보려면 오른쪽 스위치 옆의 동그라미 화살표를 눌러보면 됩니다.

이렇게 뜨면 성공입니다.

이렇게 뜨면 설정 다시 체크해보세요. 서버 설정이 끝나면 아래와 같이 사용할 수 있습니다.

이렇게 LM Studio에서 모델이 로딩되고 사용할 수 있는 것을 확인할 수 있습니다.

레퍼런스

https://svrforum.com/software/1964820

'HomeLAB > Mac(OSX, macOS)' 카테고리의 다른 글

[Mac] llama.cpp 로컬에서 설치하고 간단하게 찍먹해보기 (0) 2025.02.21